謝克指出,AI的競爭格局正在發生根本性轉變,焦點不再侷限於單顆晶片效能,而是涵蓋自研加速器、資料中心網路、機架架構設計,到數據與開發平台,以及最終應用的「端到端AI基礎設施」。他進一步將AI基礎設施劃分為三個層次:

第一是基礎設施層,涵蓋GPU/TPU等加速器、儲存與資料中心網路。

第二是資料與開發層,包括數據平台、資料庫與AI開發工具。

第三則是應用層,例如Google搜尋、YouTube、Android、Workspace與Gemini等服務。謝克強調,AI真正的價值不僅在於模型演進,更在於能否快速擴展至大規模使用者並解決實際問題。

在規模化挑戰上,謝克透露,目前單一AI集群已可達9,000顆以上加速器,對互連架構提出極高要求,需要TB/s級頻寬與極低延遲。由於任何元件失效都可能拖累整體效能,因此必須引入光學電路交換技術,確保系統具備可靠性與彈性重構能力。同時,能源效率問題亦成為大型資料中心不可迴避的課題。

謝克也於論壇中展示Google光學互連技術的發展路線圖,顯示單通道傳輸速率自2018年的50G逐步提升,2024年已達200G,並預計2027年將推進至400G PAM4,模組整體頻寬突破3.2Tbps。

謝克表示,光學互連將支撐AI叢集的「scale-up」與「scale-out」兩大需求:前者負責超級計算集群(Pod)內部的高速低延遲溝通,後者則連結跨資料中心的長距離網路並提供更高冗餘性,確保超大規模AI運算能持續擴展。

他進一步指出,AI算力需求的增速已經遠超摩爾定律,傳統電互連技術難以應付萬卡等級叢集的挑戰。矽光子技術因而成為未來的核心,包括矽光子收發器、共封裝光學,以及資料中心級光交換,都是產業投資與合作的焦點。謝克直言,這是一場跨領域、跨供應鏈的合作競賽,唯有晶片設計商、雲端服務商與光電技術供應鏈共同投入,才能推動AI基礎設施邁向下一世代。

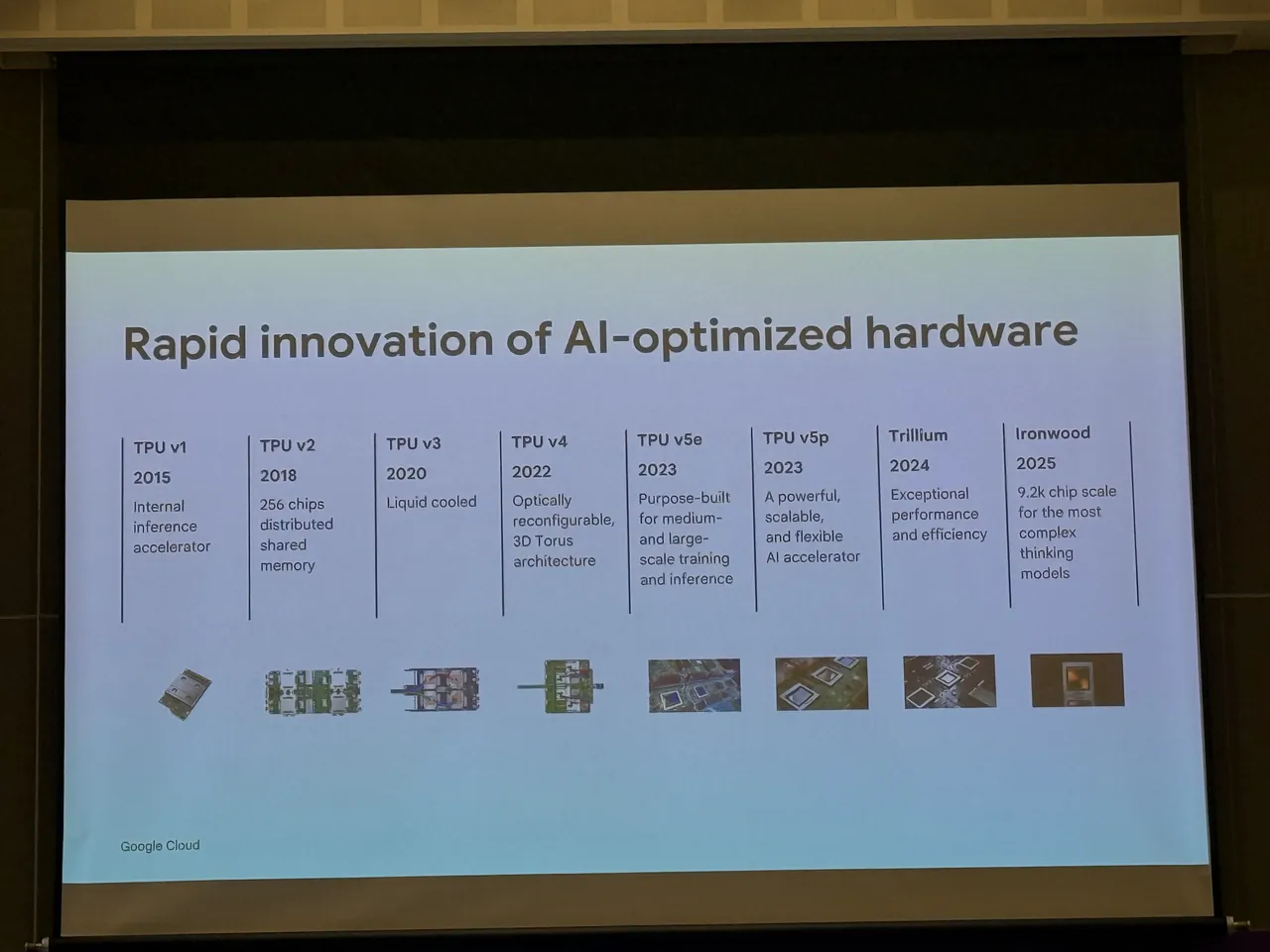

值得注意的是,Google同步揭示自研TPU的十年演進,展現AI專用晶片的快速迭代。自2015年TPU v1問世以來,陸續推出液冷的TPU v3、具光學可重構與3D Torus架構的TPU v4,以及支援中大型訓練的TPU v5e與靈活擴展的TPU v5p。2024年則推出兼具效能與能效的Trillium,2025年預計發布Ironwood,單一集群規模將達9,200顆晶片,專為最複雜的AI思考型模型打造。這條TPU路線圖正是謝克所言「端到端基礎設施」理念的縮影,從晶片到叢集,逐步建構支撐全球級AI應用的完整生態。