供應鏈方面, NVIDIA RTX PRO 伺服器提供多種配置,合作夥伴涵蓋Cisco、Dell Technologies、HPE、Lenovo 與 Supermicro,以及研華、安提國際、Aivres、永擎電子、華碩、仁寶、Eviden、鴻海科技集團、技嘉、英業達、神達電腦、微星、和碩聯合科技、雲達、緯創及緯穎等。

雲端服務供應商 CoreWeave 和 Google Cloud 現已提供由 NVIDIA RTX PRO 6000 Blackwell 伺服器版 GPU 加速的運算執行個體,AWS、Nebius 和 Vultr 也將於今年稍晚推出更多相關執行個體。

相關新聞:輝達推RTX PRO伺服器!鴻海、台積電等大廠搶先採用 揭AI應用藍圖

輝達表示, NVIDIA RTX PRO 伺服器能加速代理型 AI 與推理工作負載,協助研究人員與開發者建構並部署具備即時學習、適應與互動能力的自主系統。例如,NVIDIA Llama Nemotron Super 推理模型在單顆 RTX PRO 6000 GPU 上以 NVFP4 運行時,相較於 H100 GPU 以 FP8 運行,性價比最高可提升 3 倍,能以更低成本實現更準確的推理。為了開發高效的物理 AI 系統,企業可先在模擬環境中測試與最佳化機器人車隊,再部署至實際工廠; NVIDIA RTX PRO 伺服器在數位孿生、模擬與合成資料生成等工作流程中,效能較搭載 L40S GPU 的系統提升最多達 4 倍,推動工業 AI 與物理 AI 發展。

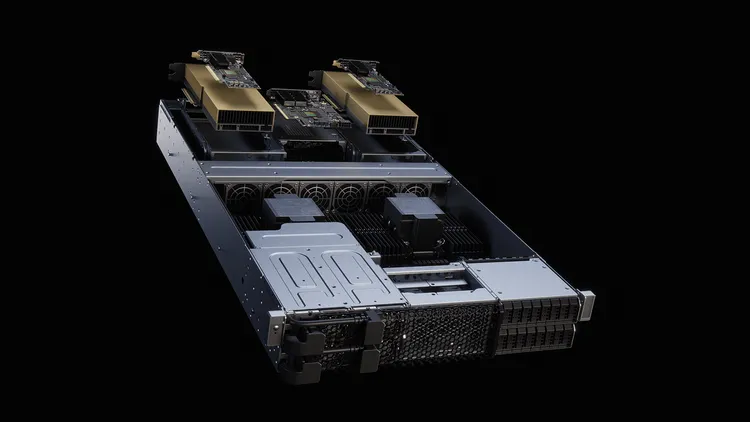

NVIDIA RTX PRO 伺服器以最大化彈性為設計核心,支援 Windows、Linux 與主流虛擬機器管理程式,讓 IT 管理人員可在不影響效能的情況下大規模部署 AI。其採用風冷、基於 PCIe 的 x86 架構,幾乎能執行所有企業級工作負載,並具備安全性、可管理性與可維護性,確保企業能以熟悉的環境快速升級至 AI 世代。

NVIDIA RTX PRO 伺服器與整個 Blackwell 架構產品組合,皆由 NVIDIA AI Enterprise 軟體平台支援,內含 NVIDIA NIM 微服務及多樣 AI 框架、程式庫與工具,讓企業可在雲端、資料中心與工作站上部署。

NVIDIA RTX PRO 伺服器已納入 Enterprise AI Factory 驗證設計,適用於希望在本地建構 AI 工廠的企業,並整合於 NVIDIA AI 資料平台,作為可客製化的參考設計,用於打造現代化儲存系統,以支援企業級代理型 AI。同時,RTX PRO 伺服器結合 Omniverse 程式庫與 Cosmos 世界基礎模型,能協助物理 AI 開發者建構並部署各類應用,包括工廠與機器人模擬的數位孿生,或大規模合成資料生成。